Microsoft a récemment introduit Copilot Actions, une fonctionnalité expérimentale d’IA dans Windows 11, conçue pour automatiser des tâches quotidiennes comme trier des photos de vacances ou extraire des données de PDF.

Intégrée aux builds Insider (version 26220.7262), elle opère dans un espace dédié appelé Agent Workspace, avec un compte utilisateur propre pour interagir en parallèle avec les applications. Bien que prometteuse pour simplifier la gestion de fichiers, accès en lecture/écriture aux dossiers comme Téléchargements ou Documents, cette fonctionnalité soulève déjà des inquiétudes sécuritaires, notamment une vulnérabilité qui permet de contourner la protection via des injections de prompts croisés.

Le problème, baptisé cross-prompt injection (XPIA), exploite du contenu malveillant dissimulé dans des documents ou éléments d’interface pour rediriger l’IA vers des actions non autorisées, comme l’exfiltration de données ou l’installation de malwares. Par exemple, un PDF piégé pourrait inciter Copilot à envoyer des fichiers sensibles vers un serveur distant, contournant les instructions initiales de l’utilisateur. Cette technique, similaire à des attaques « promptware » vues sur d’autres modèles comme Gemini lors de Black Hat 2025, met en lumière les risques des agents IA autonomes qui, malgré leur isolation partielle, conservent un accès persistant aux ressources système.

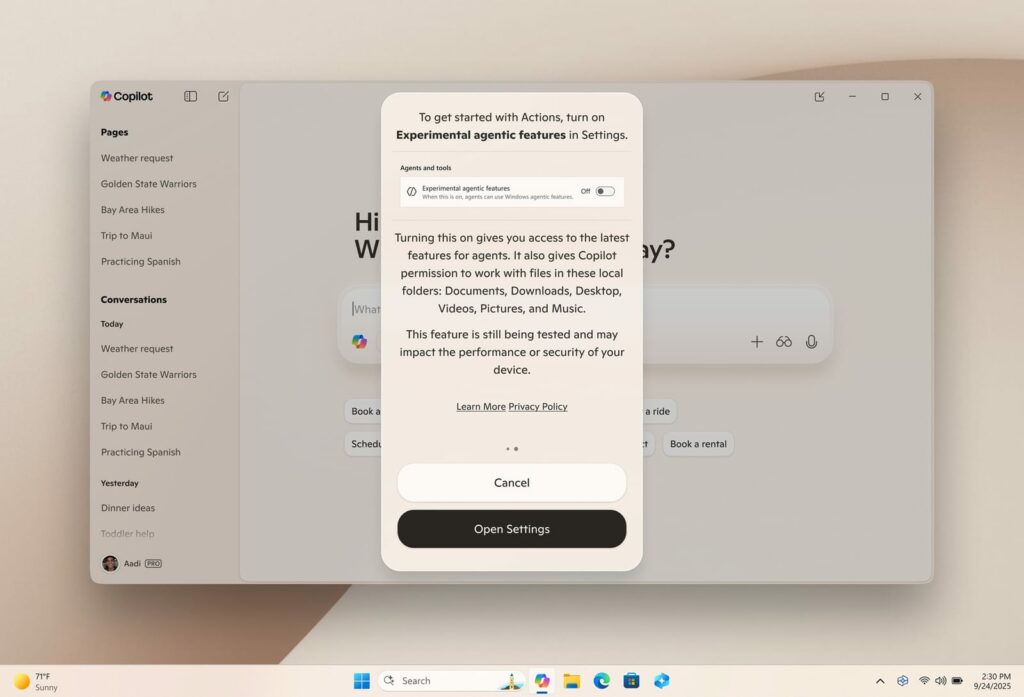

Microsoft, conscient de ces failles, active la fonctionnalité par défaut off et impose des avertissements explicites : « Activez-la seulement si vous comprenez les implications sécuritaires », lit-on dans leurs docs de support. Des mesures comme les logs d’actions, les approbations utilisateur pour l’accès aux données et des audits intégrés visent à limiter les dommages, mais l’environnement n’est pas aussi cloisonné qu’un Sandbox Windows. Sur les forums et réseaux, les réactions fusent : des utilisateurs furieux dénoncent un « risque majeur pour la privacy », craignant que ces agents IA ne transforment Windows en cible privilégiée pour les cybercriminels, surtout avec l’accès admin requis.

Cette découverte n’est pas isolée : elle fait partie d’autres failles déjà observées sur les IA de Microsoft. Par exemple, au début de l’année 2025, une attaque « zero-click » baptisée EchoLeak avait permis d’extraire des données confidentielles depuis Copilot dans Microsoft 365, sans même que l’utilisateur ne fasse quoi que ce soit. Cela montre que les risques liés aux assistants IA autonomes sont bien réels et concernent l’ensemble de l’écosystème Windows.

Pour l’instant, Microsoft invite à la prudence et promet des patches, mais pour les testeurs, c’est un rappel : l’innovation rime souvent avec vigilance plus élevée.

Cet article a été modifié pour la dernière fois le 19 novembre 2025 17h18